《大数据处理之首要过程:数据采集的全面解析》

一、引言

在当今数字化时代,大数据已经渗透到各个领域,从商业智能到科学研究,从医疗保健到社交媒体,要充分挖掘大数据的价值,就需要了解大数据处理的完整过程,大数据处理过程是一个复杂的多步骤流程,而这一流程首先是数据采集过程。

二、数据采集的定义与重要性

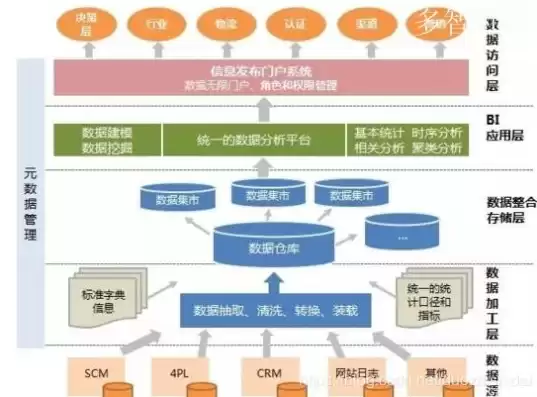

图片来源于网络,如有侵权联系删除

数据采集是指从各种数据源中收集数据的过程,这些数据源可以是极为多样化的,包括传感器网络、社交媒体平台、日志文件、数据库系统等,数据采集是大数据处理的基础,如果没有准确、全面的数据采集,后续的数据分析、挖掘等环节都将成为无源之水。

在物联网(IoT)环境中,数以亿计的设备(如智能家居设备、工业传感器等)持续产生海量数据,这些设备通过网络将数据传输到数据采集点,如果数据采集出现问题,比如数据丢失或者采集不及时,那么基于这些数据的智能决策(如智能家居系统中的能源管理优化、工业生产中的故障预测等)将无法有效进行。

三、数据采集的主要方式

1、传感器采集

- 在工业领域,传感器被广泛应用于采集各种物理量数据,如温度、压力、湿度等,在自动化流水生产线上,温度传感器会实时监测设备运行时的温度情况,这些传感器将物理信号转换为电信号,再通过模数转换将其转换为数字信号,然后将数据传输到数据采集系统。

- 在环境监测方面,气象传感器网络可以采集风速、风向、空气质量等数据,这些数据对于气象研究、环境保护等具有重要意义。

2、网络爬虫采集

- 对于互联网上的公开信息,如新闻网站、社交媒体平台等的数据采集,网络爬虫是一种常用的手段,新闻媒体机构可能会使用网络爬虫从各大新闻网站采集新闻资讯,用于新闻聚合、舆情分析等业务,网络爬虫按照一定的规则自动访问网页,并提取网页中的文本、图片、链接等信息。

- 网络爬虫的使用需要遵循相关法律法规和网站的使用条款,以避免侵犯他人权益或对网站造成过度访问压力。

3、日志文件采集

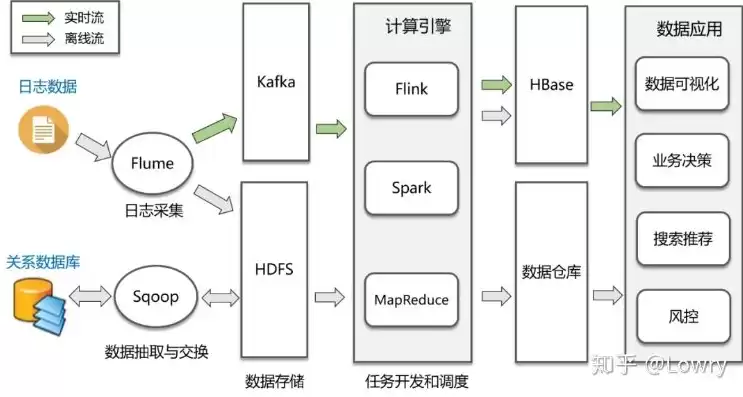

图片来源于网络,如有侵权联系删除

- 许多软件系统和网络设备都会生成日志文件,这些日志文件记录了系统的运行状态、用户操作等信息,Web服务器的访问日志可以记录每个用户的访问时间、访问的页面、IP地址等信息,通过采集这些日志文件,可以分析网站的流量模式、用户行为等,为网站的优化、安全防护等提供依据。

四、数据采集面临的挑战

1、数据量巨大

- 随着数据源的不断增加和数据产生速度的加快,数据采集系统需要处理的数据量呈爆炸式增长,在大型电子商务平台的促销活动期间,服务器每秒可能会收到数以万计的用户请求,每个请求都会产生相应的数据,这对数据采集系统的处理能力提出了极高的要求。

2、数据多样性

- 不同数据源产生的数据格式和类型差异很大,传感器数据可能是结构化的数值数据,而社交媒体数据则可能是半结构化或非结构化的文本、图像、视频等,数据采集系统需要能够兼容多种数据类型,并且能够对不同格式的数据进行有效的转换和整合。

3、数据质量

- 采集到的数据可能存在不准确、不完整、不一致等质量问题,传感器可能由于环境干扰或自身故障而产生错误数据;网络传输过程中可能会出现数据丢失或损坏的情况,确保数据质量是数据采集过程中的一个重要任务,需要通过数据清洗、校验等技术来解决。

五、数据采集技术的发展趋势

1、智能化采集

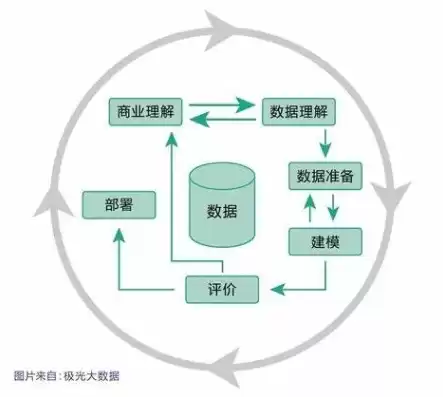

图片来源于网络,如有侵权联系删除

- 未来的数据采集将更加智能化,传感器将具备自我诊断和自适应能力,能够根据环境变化自动调整采集参数,提高数据采集的准确性和效率,网络爬虫也将更加智能,能够根据语义理解有针对性地采集更有价值的信息。

2、边缘计算辅助采集

- 边缘计算将在数据采集过程中发挥越来越重要的作用,在物联网环境中,边缘设备可以在本地对采集的数据进行初步处理,如数据过滤、聚合等,减少需要传输到中心服务器的数据量,降低网络传输压力,提高数据采集和处理的整体效率。

3、安全增强

- 随着数据安全问题的日益突出,数据采集过程中的安全防护将不断加强,这包括数据加密传输、身份认证、访问控制等技术的应用,确保采集到的数据的安全性和隐私性。

六、结论

数据采集作为大数据处理过程的首要环节,其重要性不可忽视,准确、全面、高效的数据采集是实现大数据价值挖掘的前提,尽管面临着数据量巨大、数据多样性和数据质量等诸多挑战,但随着智能化采集、边缘计算辅助采集和安全增强等发展趋势的推进,数据采集技术将不断发展完善,为大数据处理的后续环节提供坚实的基础。

评论列表