《Python数据分析工具全解析:探索多样的数据分析利器》

一、引言

在当今数据驱动的时代,数据分析成为了各个领域获取有价值信息、做出明智决策的关键,Python作为一种功能强大且广泛使用的编程语言,拥有众多优秀的数据分析工具,这些工具各有特色,能够满足从数据获取、清洗、探索性分析到复杂建模等一系列需求。

二、Numpy(数值计算库)

1、基本功能

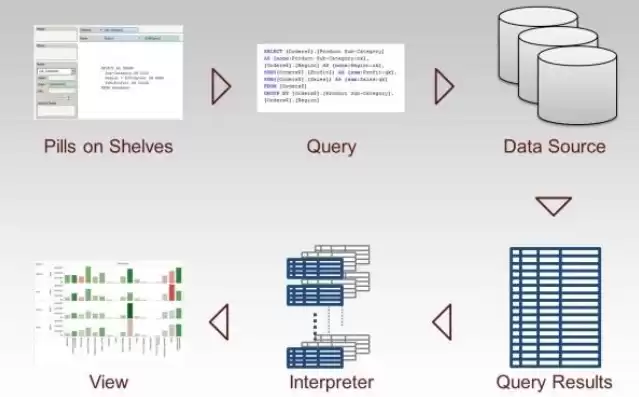

图片来源于网络,如有侵权联系删除

- Numpy是Python中用于科学计算的基础库,它提供了高性能的多维数组对象(ndarray)以及处理这些数组的函数,我们可以轻松地创建数组,如import numpy as np; a = np.array([1, 2, 3])。

- 数组操作方面,Numpy支持数组的索引、切片、重塑等操作,对于大规模数据的数值计算,Numpy的向量化操作能够显著提高计算速度,在进行矩阵乘法时,使用Numpy的dot函数比传统的循环计算要快很多。

2、在数据分析中的应用

- 在数据预处理阶段,Numpy可以用于对数据进行简单的数值转换,对数据集中的某一列数值进行标准化操作,将其转换为均值为0,标准差为1的数值,在处理图像数据(图像数据可以看作是多维数组)等方面,Numpy也是不可或缺的工具。

三、Pandas(数据处理与分析库)

1、数据结构

- Pandas引入了两种主要的数据结构:Series和DataFrame,Series是一维的标记数组,可以看作是带标签的数组或字典,DataFrame则是二维的表格型数据结构,类似于关系型数据库中的表,我们可以通过import pandas as pd; df = pd.read_csv('data.csv')轻松地从CSV文件读取数据到DataFrame中。

- 数据操作方面,Pandas提供了丰富的函数用于数据的筛选、排序、分组和聚合操作,要筛选出DataFrame中某一列值大于某个阈值的行,可以使用df[df['column_name'] > value],分组操作可以按照某一列的值对数据进行分组,然后进行聚合计算,如计算每个组的平均值、总和等。

2、数据清洗与探索

- 在数据清洗中,Pandas可以处理缺失值,可以使用df.fillna()方法填充缺失值,或者使用df.dropna()方法删除包含缺失值的行或列,在探索性数据分析阶段,Pandas可以快速计算数据的描述性统计信息,如均值、中位数、标准差等,通过df.describe()函数即可实现。

四、Matplotlib(数据可视化库)

1、绘图类型

- Matplotlib提供了多种绘图类型,包括折线图、柱状图、散点图、饼图等,绘制一个简单的折线图可以使用以下代码:

```python

import matplotlib.pyplot as plt

x = [1, 2, 3, 4]

y = [5, 4, 6, 2]

plt.plot(x, y)

plt.show()

```

- 它还支持在同一图中绘制多个子图,通过subplot函数可以方便地布局多个图形,这对于比较不同数据集或不同变量之间的关系非常有用。

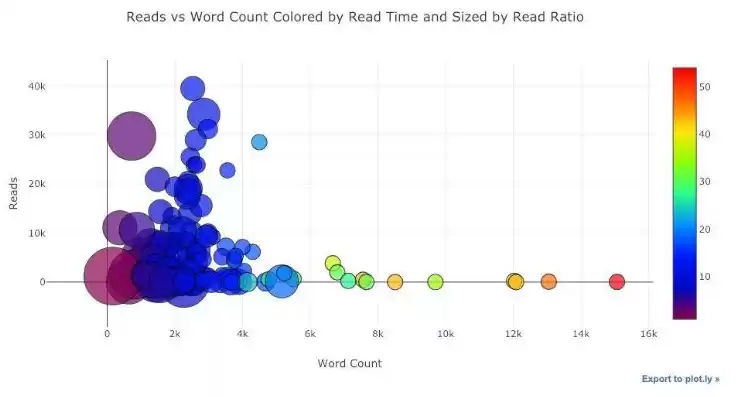

图片来源于网络,如有侵权联系删除

2、定制与美化

- Matplotlib允许对图形进行高度定制,可以设置坐标轴标签、标题、图例等。plt.xlabel('X - axis')、plt.ylabel('Y - axis')、plt.title('My Plot'),还可以调整图形的颜色、线条样式、标记样式等,使图形更加美观和易于理解。

五、Seaborn(统计数据可视化库)

1、基于统计的可视化

- Seaborn建立在Matplotlib之上,专门用于统计数据的可视化,它提供了一些高级的绘图函数,如distplot用于绘制单变量的分布,pairplot用于绘制数据集中多个变量之间的关系矩阵(包括散点图、直方图等)。

- 对于一个包含多个数值型变量的数据集,使用pairplot可以快速直观地看到变量之间的相关性、分布情况等,Seaborn的绘图风格也比较美观,默认的样式比Matplotlib更加现代化。

2、分类数据可视化

- 在处理分类数据时,Seaborn提供了诸如barplot(用于显示分类变量的均值等统计信息)、boxplot(用于显示数据的分布和异常值情况)等函数,这些函数可以帮助分析人员更好地理解分类数据的特征和不同类别之间的差异。

六、Scikit - learn(机器学习库)

1、机器学习算法

- Scikit - learn包含了丰富的机器学习算法,如分类算法(决策树、支持向量机、逻辑回归等)、回归算法(线性回归、岭回归等)、聚类算法(K - 均值聚类等),要使用决策树进行分类,可以按照以下步骤:

```python

from sklearn.tree import DecisionTreeClassifier

from sklearn.model_selection import train_test_split

from sklearn.datasets import load_iris

iris = load_iris()

X_train, X_test, y_train, y_test = train_test_split(iris.data, iris.target, test_size = 0.2)

clf = DecisionTreeClassifier()

clf.fit(X_train, y_train)

```

- 它还提供了模型评估指标,如准确率、召回率、均方误差等,用于评估模型的性能。from sklearn.metrics import accuracy_score; accuracy = accuracy_score(y_test, clf.predict(X_test))。

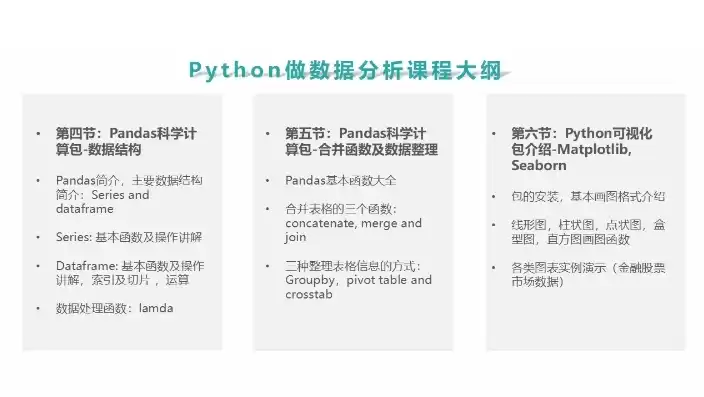

图片来源于网络,如有侵权联系删除

2、数据预处理与管道

- 在数据预处理方面,Scikit - learn提供了标准化、归一化等工具,它还支持构建管道(Pipeline),将数据预处理步骤和模型训练步骤组合在一起,方便进行模型的调优和部署。

七、Statsmodels(统计分析库)

1、统计模型构建

- Statsmodels可以用于构建各种统计模型,如线性回归模型、广义线性模型等,构建一个简单的线性回归模型:

```python

import statsmodels.api as sm

import pandas as pd

data = pd.read_csv('data.csv')

X = data[['x1', 'x2']]

y = data['y']

X = sm.add_constant(X)

model = sm.OLS(y, X).fit()

```

- 它可以输出模型的详细统计信息,如系数估计值、标准误差、t - 统计量、p - 值等,帮助用户进行统计推断和模型解释。

2、时间序列分析

- 在时间序列分析方面,Statsmodels提供了诸如自回归模型(AR)、移动平均模型(MA)、自回归移动平均模型(ARMA)等的构建和分析功能,可以对时间序列数据进行拟合、预测和模型诊断等操作。

八、结论

Python中的这些数据分析工具相互配合,形成了一个完整的数据分析生态系统,从数据的基础处理到复杂的统计分析和机器学习建模,以及最后的可视化展示,不同的工具在各个环节发挥着关键作用,无论是数据科学家、分析师还是研究人员,熟练掌握这些工具能够更高效地从数据中挖掘出有价值的信息,从而为解决实际问题提供有力的支持。

评论列表