本文目录导读:

《负载均衡服务器配置实验报告:服务器连接与优化策略》

随着网络服务的规模不断扩大,单一服务器往往难以承受大量的并发请求,负载均衡服务器的出现有效解决了这一问题,它能够将网络流量合理地分配到多个后端服务器上,提高系统的整体性能、可靠性和可扩展性,本实验旨在深入研究负载均衡服务器与后端服务器的连接配置,并通过实验分析其在不同场景下的表现。

实验环境

1、硬件设备

图片来源于网络,如有侵权联系删除

- 负载均衡服务器:配置为高性能服务器,具有多核心处理器、大容量内存和高速网络接口卡,以确保能够高效地处理网络流量的分发任务。

- 后端服务器:若干台普通服务器,配置足以满足实验中的服务提供需求,例如Web服务的提供等。

2、软件环境

- 负载均衡服务器操作系统:CentOS 7,选择CentOS是因为其稳定性和广泛的社区支持,在负载均衡服务器上安装了Nginx作为负载均衡器,Nginx以其高性能、低内存占用和强大的反向代理功能而著称。

- 后端服务器操作系统:同样为CentOS 7,根据不同的服务需求安装了相应的软件,如Apache用于提供Web服务。

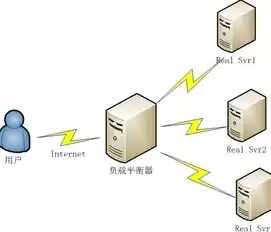

负载均衡服务器与后端服务器的连接方式

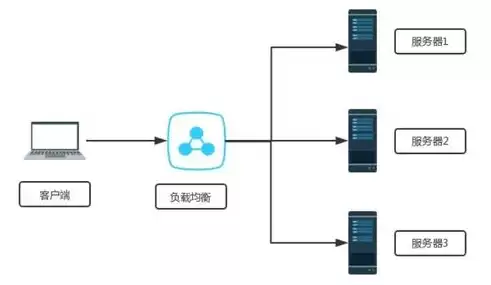

(一)网络拓扑结构

负载均衡服务器与后端服务器通过局域网(LAN)进行连接,在网络拓扑中,负载均衡服务器位于前端,直接面向外部网络请求,后端服务器位于内部网络,与负载均衡服务器处于同一子网内,这种拓扑结构的优点是通信延迟低,便于管理和配置。

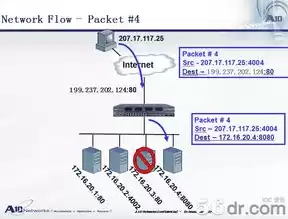

(二)IP地址分配

1、负载均衡服务器

- 负载均衡服务器具有公网IP地址,用于接收来自外部网络的请求,它在内部网络也有一个私有IP地址,用于与后端服务器进行通信。

- 公网IP地址为202.100.100.100,内部私有IP地址为192.168.1.1。

2、后端服务器

- 后端服务器配置私有IP地址,如192.168.1.2 - 192.168.1.10等,这些IP地址用于与负载均衡服务器进行内部通信,接收负载均衡服务器分发过来的请求。

(三)端口配置

1、负载均衡服务器

- 在Nginx的配置中,监听常见的服务端口,如80端口(用于HTTP服务)和443端口(用于HTTPS服务),当外部请求到达负载均衡服务器的这些端口时,Nginx将根据预先定义的规则将请求转发到后端服务器。

- 在Nginx的配置文件中,有类似“listen 80;”和“server_name example.com;”的配置语句,server_name”指定了服务的域名,当请求的域名匹配时,Nginx会处理该请求。

图片来源于网络,如有侵权联系删除

2、后端服务器

- 后端服务器上运行的服务(如Apache)也监听相应的端口,通常为80端口(如果是提供Web服务),这样,当负载均衡服务器将请求转发到后端服务器的特定IP地址时,后端服务器能够正确接收并处理该请求。

负载均衡算法的配置与实现

1、轮询算法(Round - Robin)

- 轮询算法是最简单的负载均衡算法之一,在Nginx中,通过简单的配置即可实现,在Nginx的配置文件中,对于后端服务器池的配置如下:

```nginx

upstream backend_pool {

server 192.168.1.2;

server 192.168.1.3;

server 192.168.1.4;

}

```

- 当有请求到达时,Nginx会按照顺序依次将请求分配到192.168.1.2、192.168.1.3、192.168.1.4等后端服务器上,循环往复,这种算法的优点是简单公平,每个后端服务器都会得到均等的请求分配机会,但是它没有考虑后端服务器的实际负载情况,可能会导致部分负载较重的服务器性能下降。

2、加权轮询算法(Weighted Round - Robin)

- 加权轮询算法在轮询算法的基础上考虑了后端服务器的性能差异,如果192.168.1.2服务器的性能是192.168.1.3服务器的两倍,我们可以在Nginx配置中为它们设置不同的权重。

```nginx

upstream backend_pool {

server 192.168.1.2 weight = 2;

图片来源于网络,如有侵权联系删除

server 192.168.1.3 weight = 1;

server 192.168.1.4 weight = 1;

}

```

- 这样,Nginx在分配请求时,会按照权重比例进行分配,192.168.1.2服务器将获得两倍于192.168.1.3和192.168.1.4服务器的请求分配机会,这种算法能够更好地利用高性能服务器的资源,提高整体系统的性能。

实验测试与结果分析

1、测试工具

- 使用ApacheBench(ab)工具进行性能测试,ApacheBench是一个简单但功能强大的HTTP服务器性能测试工具,可以模拟多个并发用户对服务器进行请求。

2、测试场景与结果

场景一:轮询算法下的性能测试

- 配置Nginx使用轮询算法,然后使用ab工具对负载均衡服务器的域名进行测试,测试参数设置为并发用户数为100,请求总数为1000。

- 测试结果显示,后端服务器接收到的请求数量大致相等,但是在高并发情况下,部分服务器的响应时间较长,这是因为轮询算法没有考虑服务器的实际负载情况,导致负载较重的服务器响应速度下降。

场景二:加权轮询算法下的性能测试

- 重新配置Nginx为加权轮询算法,将性能较好的服务器权重设置为较高值,再次使用相同的ab工具参数进行测试。

- 结果表明,性能较好且权重较高的服务器处理了更多的请求,并且整体的响应时间得到了优化,系统的吞吐量也有所提高,说明加权轮询算法能够根据服务器的性能合理分配负载,提高系统的整体性能。

本实验深入研究了负载均衡服务器与后端服务器的连接配置以及负载均衡算法的应用,通过网络拓扑结构的搭建、IP地址和端口的合理配置,实现了负载均衡服务器与后端服务器的有效连接,对比轮询算法和加权轮询算法的实验结果表明,加权轮询算法在考虑后端服务器性能差异的情况下,能够更好地分配负载,提高系统的整体性能和响应速度,在实际的网络服务部署中,应根据后端服务器的性能特点和业务需求,选择合适的负载均衡算法和配置策略,以提高系统的可靠性和可扩展性,未来的研究可以进一步探索更复杂的负载均衡算法,如基于服务器实时负载的动态负载均衡算法等,以适应更加复杂多变的网络服务环境。

评论列表