《解析大数据处理的六大流程:从数据采集到价值呈现》

图片来源于网络,如有侵权联系删除

大数据处理是一个复杂而系统的过程,主要可概括为以下六个流程:数据采集、数据存储、数据清洗、数据转换、数据分析和数据可视化。

一、数据采集

数据采集是大数据处理的源头,在当今数字化时代,数据来源极为广泛,从各种传感器获取数据,例如物联网设备中的温度传感器、湿度传感器等,它们能够实时采集环境数据并传送到数据处理中心,在工业领域,机器设备上的传感器可以收集设备的运行状态数据,如转速、压力、振动频率等,这些数据有助于预测设备故障,提高生产效率,网络是数据采集的重要途径,包括社交媒体平台、电子商务网站等,社交媒体平台上用户的行为数据(如点赞、评论、分享)、个人信息(如年龄、性别、地理位置)等都是海量的数据来源,电子商务网站则可以采集用户的购买行为数据,如购买商品的种类、价格、购买时间等,这些数据对于企业了解用户需求、优化营销策略具有重要意义。

二、数据存储

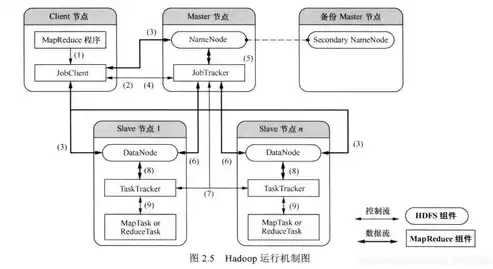

采集到的数据需要妥善存储以便后续处理,由于大数据的规模巨大,传统的关系型数据库往往难以满足需求,非关系型数据库(NoSQL)应运而生,例如Hadoop分布式文件系统(HDFS),它具有高容错性、高扩展性等特点,适合存储海量的结构化和非结构化数据,在存储数据时,还需要考虑数据的安全性和可靠性,数据中心通常会采用冗余存储的方式,将数据存储在多个节点上,以防止数据丢失,通过加密技术对数据进行加密,保护数据的隐私性,防止数据泄露。

图片来源于网络,如有侵权联系删除

三、数据清洗

原始数据往往存在噪声、缺失值和错误值等问题,数据清洗就是要解决这些问题,对于缺失值,可以采用填充的方法,如使用均值、中位数或者根据数据的逻辑关系进行填充,对于错误值,需要通过数据验证规则进行识别和修正,在采集用户年龄数据时,如果出现大于150岁的值,显然是错误的,就需要进行修正或者删除,数据清洗还包括去除重复数据,以减少数据冗余,提高数据质量。

四、数据转换

经过清洗的数据可能还需要进行转换,以适应后续的分析需求,数据转换包括数据标准化、数据编码等操作,数据标准化可以将不同量级的数据转化为统一的标准,例如将身高数据(厘米)和体重数据(千克)转化为无量纲的数据,以便进行比较和分析,数据编码则是将分类数据转化为数字形式,例如将性别中的男和女分别编码为0和1,方便在数据分析算法中使用。

五、数据分析

图片来源于网络,如有侵权联系删除

这是大数据处理的核心环节,数据分析方法众多,包括描述性分析、探索性分析、预测性分析等,描述性分析主要是对数据的基本特征进行统计描述,如计算均值、标准差、频数等,探索性分析则是通过数据可视化等手段探索数据之间的关系,预测性分析利用机器学习和数据挖掘算法,如线性回归、决策树、神经网络等,对未来的数据趋势进行预测,在金融领域,可以根据历史股票数据预测股票价格走势;在医疗领域,可以根据患者的病历数据预测疾病的发生风险。

六、数据可视化

数据可视化是将数据分析的结果以直观的图形、图表等形式展示出来,这样做的好处是能够让决策者和非技术人员更容易理解数据背后的含义,常见的可视化形式包括柱状图、折线图、饼图、箱线图等,用柱状图展示不同地区的销售额对比,用折线图展示某产品在一段时间内的销售趋势,通过数据可视化,企业可以快速发现问题和机会,做出更明智的决策。

大数据处理的这六个流程是一个有机的整体,每个环节都不可或缺,从数据采集开始,经过存储、清洗、转换等处理步骤,最终通过分析和可视化呈现数据的价值,为企业、科研机构和社会各界提供有力的决策支持和创新动力。

评论列表