《负载均衡实现方案:构建高效、稳定的网络服务架构》

一、引言

在当今数字化时代,随着互联网应用的不断发展和用户数量的急剧增加,如何确保网络服务能够高效、稳定地运行成为了一个至关重要的问题,负载均衡作为一种关键技术,能够有效地将网络流量分配到多个服务器上,提高系统的整体性能、可靠性和可扩展性,本文将详细探讨负载均衡的实现方案。

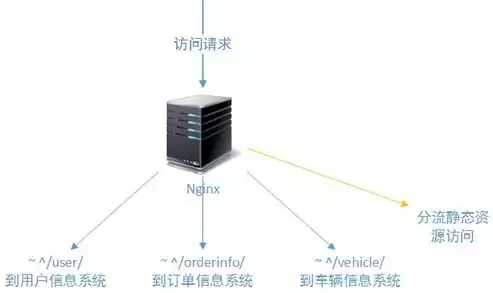

二、负载均衡的基本原理

图片来源于网络,如有侵权联系删除

负载均衡器位于客户端和服务器集群之间,它负责接收客户端的请求,并根据预先设定的算法将请求转发到合适的服务器上,常见的负载均衡算法包括轮询、加权轮询、最少连接数、加权最少连接数等。

轮询算法简单地按照顺序依次将请求分配到服务器集群中的各个服务器上,加权轮询则考虑了服务器的性能差异,为性能较强的服务器分配更高的权重,从而使其能够处理更多的请求,最少连接数算法会将请求发送到当前连接数最少的服务器上,以确保各个服务器的负载相对均衡,加权最少连接数结合了服务器的性能权重和当前连接数情况进行请求分配。

三、硬件负载均衡方案

1、传统硬件负载均衡器

- 专业的硬件负载均衡设备,如F5 Big - IP等,具有高性能、高可靠性的特点,它们能够处理大量的并发请求,并且提供了丰富的功能,如SSL卸载、内容过滤等,这些设备通常采用专用的硬件芯片和操作系统,能够在网络层、传输层和应用层进行流量的分发。

- 优点:

- 性能卓越,能够满足大规模企业级应用的需求。

- 稳定性高,具备冗余设计,不易出现故障。

- 功能丰富,可对网络流量进行深度的优化和管理。

- 缺点:

- 成本高昂,包括设备采购、维护和升级成本。

- 硬件设备的扩展性相对有限,当业务规模急剧增长时可能需要更换更高型号的设备。

2、基于网络设备的负载均衡

- 一些高端的网络交换机和路由器也可以实现负载均衡功能,某些企业级交换机可以通过配置虚拟服务器组和负载均衡策略来实现对服务器集群的流量分发。

- 优点:

- 可以利用现有的网络设备,减少额外的硬件投资。

- 对于网络架构的集成性较好,便于统一管理。

- 缺点:

- 负载均衡功能可能相对简单,不如专业硬件负载均衡器功能强大。

- 在处理复杂的应用层流量时可能存在局限性。

四、软件负载均衡方案

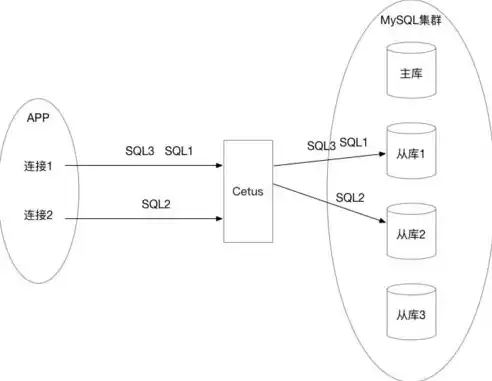

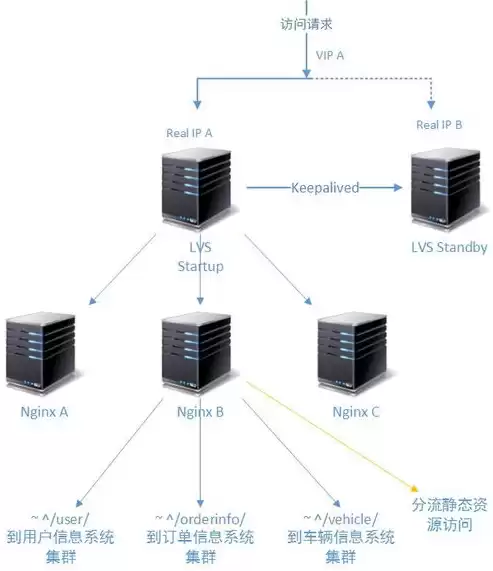

1、Nginx负载均衡

- Nginx是一款开源的高性能Web服务器、反向代理服务器和电子邮件(IMAP/POP3)代理服务器,同时也具有强大的负载均衡能力。

图片来源于网络,如有侵权联系删除

- 配置简单,可以通过修改配置文件轻松实现多种负载均衡算法,在Nginx的配置中,可以设置upstream模块来定义服务器集群,并选择轮询、IP哈希等算法进行请求分发。

- 优点:

- 开源免费,成本低。

- 性能高,能够高效地处理大量并发请求。

- 可扩展性好,可以方便地添加或删除服务器节点。

- 缺点:

- 对于大规模企业级应用,可能需要进行复杂的集群配置和优化才能满足超高并发需求。

2、HAProxy负载均衡

- HAProxy是一个免费、快速并且可靠的用于提供高可用性、负载均衡以及基于TCP和HTTP应用的代理软件。

- 它支持多种负载均衡算法,并且能够对后端服务器进行健康检查,通过配置文件,可以精确地定义如何将请求转发到后端服务器,同时还可以设置连接超时、重试等参数。

- 优点:

- 性能出色,在处理高并发连接方面表现良好。

- 具有良好的可配置性,可以根据不同的应用场景进行定制化配置。

- 支持多种协议,包括TCP、HTTP等。

- 缺点:

- 配置相对复杂,需要一定的技术水平才能进行有效的配置。

五、基于云计算的负载均衡方案

1、公有云负载均衡服务

- 云服务提供商如亚马逊的Elastic Load Balancing (ELB)、阿里云的负载均衡等提供了便捷的负载均衡解决方案。

- 这些服务可以根据用户的需求自动扩展,并且与云平台上的其他服务(如虚拟机、容器等)无缝集成,以亚马逊ELB为例,它支持多种负载均衡算法,可以在多个可用区之间分发流量,提高系统的可用性。

- 优点:

- 易于使用,用户只需通过云平台的控制台进行简单配置即可。

- 可根据业务需求灵活扩展,无需担心硬件设备的采购和维护。

图片来源于网络,如有侵权联系删除

- 与云平台的集成性好,能够方便地构建完整的云计算解决方案。

- 缺点:

- 对云平台有一定的依赖,如果云平台出现故障可能会影响负载均衡服务。

- 可能存在成本问题,特别是对于高流量的应用,云负载均衡服务的费用可能较高。

2、容器编排平台中的负载均衡

- 在容器化环境中,如Kubernetes,自带了负载均衡机制,Kubernetes中的Service对象可以实现对Pod的负载均衡,它通过标签选择器来确定后端的Pod,并根据预设的算法(如随机、轮询等)将请求分发到不同的Pod上。

- 优点:

- 与容器编排紧密结合,能够实现容器化应用的高效负载均衡。

- 可以根据容器的状态自动调整负载均衡策略,如当某个Pod出现故障时自动将请求转发到其他健康的Pod上。

- 缺点:

- 学习成本较高,需要对容器技术和Kubernetes有深入的了解才能进行有效的配置。

六、负载均衡方案的选择考虑因素

1、业务需求

- 如果是大规模的企业级应用,对性能和可靠性要求极高,且预算充足,可能更适合选择硬件负载均衡方案,如F5 Big - IP,如果是中小型企业或者创业公司,开源的软件负载均衡方案(如Nginx或HAProxy)可能是更好的选择,既能满足需求又能降低成本。

2、流量特征

- 对于以HTTP流量为主的Web应用,Nginx或基于云计算的负载均衡服务可能比较合适,如果是多种协议(包括TCP等)混合的流量,HAProxy或者硬件负载均衡器可能更具优势。

3、可扩展性

- 如果业务处于快速增长阶段,需要频繁扩展服务器集群,基于云计算的负载均衡方案或者具有良好可扩展性的软件负载均衡方案(如Nginx)是比较好的选择。

4、成本

- 硬件负载均衡器成本高昂,而软件负载均衡方案大多开源免费,云计算负载均衡服务则根据使用量收费,企业需要根据自身的预算来选择合适的方案。

七、结论

负载均衡是构建高效、稳定网络服务架构的重要技术,在选择负载均衡实现方案时,需要综合考虑业务需求、流量特征、可扩展性和成本等多方面因素,无论是硬件负载均衡器、软件负载均衡方案还是基于云计算的负载均衡服务,都有各自的优缺点,企业应根据自身的实际情况进行合理的选择,以确保网络服务能够在高并发、高负载的情况下稳定运行,为用户提供优质的服务。

评论列表