本文目录导读:

分布式架构框架全解析

RPC框架

1、Dubbo

图片来源于网络,如有侵权联系删除

- Dubbo是一个高性能、轻量级的开源Java RPC框架,它提供了三大核心能力:面向接口的远程方法调用、智能容错和负载均衡,以及服务自动注册和发现。

- 在架构设计上,Dubbo采用了分层架构,它的服务提供者将服务接口暴露给注册中心,服务消费者从注册中心获取服务提供者的地址列表,然后进行远程调用,这种分层设计使得各个模块职责清晰,易于扩展和维护。

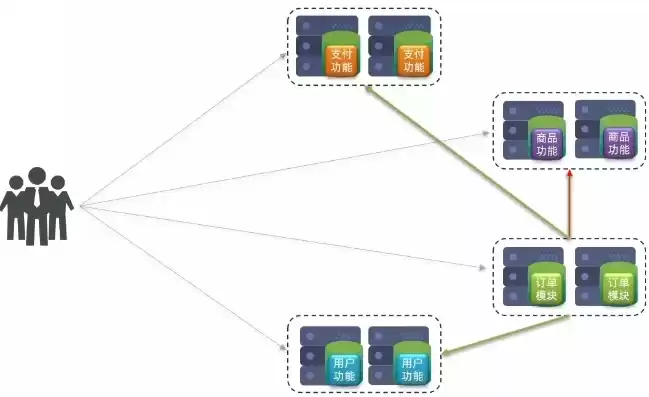

- 在实际应用场景中,Dubbo广泛应用于大型企业级Java项目的微服务架构改造,在电商系统中,商品服务、订单服务、用户服务等各个服务之间可以通过Dubbo进行高效的远程调用,它能够有效地解决服务之间的通信问题,提高系统的整体性能和可扩展性。

2、gRPC

- gRPC是由Google开发的高性能、开源的通用RPC框架,它使用Protocol Buffers作为接口定义语言(IDL)。

- gRPC的优点之一是它支持多种语言,如C++、Java、Python等,这使得不同语言编写的服务之间能够方便地进行通信,一个用C++编写的后台服务和一个用Python编写的数据分析服务可以通过gRPC进行交互。

- 从性能方面来看,gRPC采用HTTP/2协议进行数据传输,相比传统的HTTP/1.1,它具有更高的性能,如二进制格式的消息传输、头部压缩等特性,大大提高了网络传输效率。

消息队列框架

1、RabbitMQ

- RabbitMQ是一个开源的消息代理软件,它实现了高级消息队列协议(AMQP)。

- 在功能特性上,RabbitMQ具有可靠的消息传递机制,它支持多种消息传递模式,如简单模式、工作队列模式、发布/订阅模式、路由模式和主题模式等,在一个电商系统中,当用户下单后,订单服务可以将订单信息发送到RabbitMQ的工作队列模式中,然后库存管理系统和物流系统可以从队列中获取订单信息并进行相应的处理。

- RabbitMQ还具有高可用性,它可以通过集群的方式来保证消息队列的可靠性,在集群环境下,即使某个节点出现故障,消息仍然能够正常处理。

图片来源于网络,如有侵权联系删除

2、Kafka

- Kafka最初是由LinkedIn开发的分布式流处理平台,现在已经成为Apache的顶级项目。

- Kafka具有高吞吐量的特点,适合处理大规模的消息数据,它采用了分区(Partition)和副本(Replica)的机制,分区可以将数据分散到多个节点上进行存储和处理,提高了并行处理能力;副本则保证了数据的可靠性,当某个副本所在的节点出现故障时,可以从其他副本中获取数据。

- 在实际应用中,Kafka常用于日志收集系统、大数据处理系统等,在一个大型互联网公司的日志收集系统中,各个服务器上的日志可以被发送到Kafka集群中,然后再由专门的日志分析工具从Kafka中获取日志数据进行分析。

分布式数据库框架

1、Cassandra

- Cassandra是一个开源的分布式NoSQL数据库管理系统。

- 它具有高可扩展性和高可用性的特点,Cassandra采用了分布式架构,数据被分布到多个节点上存储,它没有单点故障,即使部分节点出现故障,系统仍然能够正常运行。

- 在数据模型方面,Cassandra采用了列族(Column Family)的数据模型,这种数据模型适合存储海量的、半结构化的数据,在社交网络系统中,用户的动态信息、好友关系等数据可以使用Cassandra进行存储和管理。

2、TiDB

- TiDB是一个开源的分布式关系型数据库。

- TiDB融合了传统关系型数据库的ACID事务特性和NoSQL数据库的可扩展性,它支持标准的SQL语法,对于熟悉关系型数据库的开发人员来说非常友好。

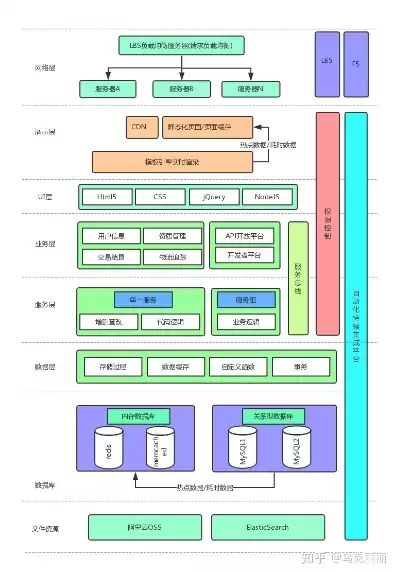

图片来源于网络,如有侵权联系删除

- 在架构上,TiDB由TiDB Server、PD(Placement Driver)和TiKV(Key - Value存储引擎)等组件组成,TiDB Server负责接收SQL请求并进行解析和优化,PD负责集群的调度和管理,TiKV则负责数据的存储和读写操作,TiDB适用于对数据一致性和可扩展性要求较高的企业级应用场景,如金融系统、电商系统等。

分布式文件系统框架

1、Ceph

- Ceph是一个开源的分布式文件系统,它同时提供了对象存储、块存储和文件存储功能。

- 在架构设计上,Ceph采用了CRUSH算法进行数据分布,CRUSH算法可以根据集群的拓扑结构和存储设备的状态动态地将数据分布到不同的存储节点上,提高了数据的可靠性和存储效率。

- Ceph具有高度的可扩展性,可以轻松地扩展到数千个节点,在云计算环境中,Ceph可以作为云存储的底层存储系统,为虚拟机、容器等提供存储服务。

2、HDFS

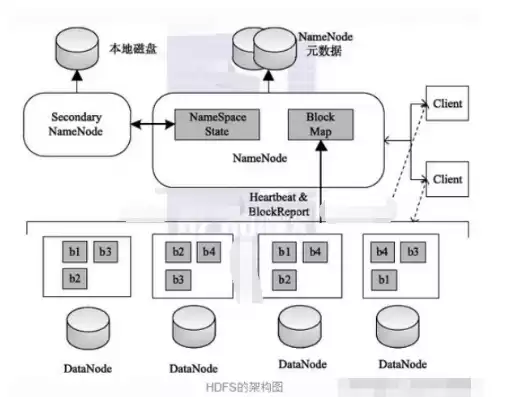

- Hadoop Distributed File System(HDFS)是Hadoop生态系统中的一个重要组成部分。

- HDFS是为了在大规模集群上存储和处理海量数据而设计的,它采用了主从架构,由一个NameNode(主节点)和多个DataNode(从节点)组成,NameNode负责管理文件系统的命名空间和数据块的映射关系,DataNode负责实际的数据存储和读写操作。

- HDFS适合存储大文件,如在大数据分析场景中,日志文件、视频文件等大文件可以存储在HDFS中,然后再通过MapReduce等计算框架进行数据处理。

分布式架构框架众多,不同的框架适用于不同的应用场景,在构建分布式系统时,需要根据具体的需求选择合适的框架。

评论列表