本文目录导读:

在大数据时代,数据处理已成为各行各业关注的焦点,随着大数据技术的不断发展,如何高效、准确地处理海量数据成为关键,本文将深入探讨大数据处理中最重要的环节——数据采集与预处理,并解析相关关键技术。

数据采集

数据采集是大数据处理的第一步,也是至关重要的环节,以下是数据采集过程中涉及的关键技术:

图片来源于网络,如有侵权联系删除

1、数据源接入:针对不同类型的数据源,如数据库、文件、网络等,采用相应的接入技术,如JDBC、ODBC、FTP等,实现数据源的连接和访问。

2、数据抽取:从数据源中提取所需数据,可利用ETL(Extract-Transform-Load)工具进行数据抽取,ETL工具具有数据清洗、转换、加载等功能,可提高数据质量。

3、数据采集框架:采用分布式数据采集框架,如Apache Flume、Apache Kafka等,实现海量数据的实时采集和传输,这些框架具有高可靠性、可扩展性等特点,适用于大规模数据采集场景。

数据预处理

数据预处理是大数据处理的核心环节,其主要目的是提高数据质量、降低后续处理的难度,以下是数据预处理过程中涉及的关键技术:

1、数据清洗:针对采集到的数据进行清洗,包括去除重复数据、修正错误数据、处理缺失数据等,数据清洗可利用数据清洗工具,如Talend、Pentaho等,实现自动化处理。

2、数据转换:将不同数据源、不同格式的数据转换为统一格式,便于后续处理,数据转换可利用ETL工具、脚本语言(如Python、Java等)实现。

图片来源于网络,如有侵权联系删除

3、数据集成:将来自不同数据源的数据进行整合,形成一个统一的数据视图,数据集成可利用数据仓库、数据湖等技术实现。

4、数据脱敏:对敏感数据进行脱敏处理,保护用户隐私,数据脱敏可利用脱敏工具,如MaskRT、DataMasker等,实现。

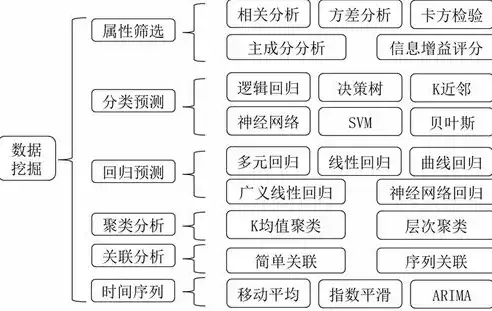

5、数据分类与聚类:根据数据特征,对数据进行分类和聚类,便于后续分析,数据分类与聚类可利用机器学习算法,如K-means、决策树等实现。

数据采集与预处理是大数据处理中最重要的环节,其质量直接影响后续分析结果的准确性,在实际应用中,我们需要关注以下方面:

1、选择合适的数据采集技术和工具,确保数据源接入的稳定性和高效性。

2、重视数据预处理,提高数据质量,降低后续处理的难度。

图片来源于网络,如有侵权联系删除

3、结合实际业务需求,选择合适的数据处理技术和方法。

4、持续关注大数据技术发展趋势,不断优化数据处理流程。

在大数据时代,数据采集与预处理环节至关重要,通过掌握相关关键技术,我们可以更好地挖掘数据价值,为企业发展提供有力支持。

评论列表