本文目录导读:

图片来源于网络,如有侵权联系删除

随着互联网技术的飞速发展,自适应网站已经成为现代网站建设的主流趋势,自适应网站能够根据用户的设备、屏幕尺寸、操作系统等因素自动调整布局和样式,为用户提供更好的浏览体验,对于开发者来说,如何获取这些自适应网站的源码成为了一个难题,本文将揭秘自适应网站源码爬取的技术原理,并提供实战应用案例,帮助开发者解决这一难题。

自适应网站源码爬取技术原理

自适应网站源码爬取主要涉及以下技术:

1、网络爬虫技术:网络爬虫是自动从互联网上抓取网页内容的一种程序,它通过分析网页结构,提取出有价值的信息,然后存储到数据库中,在自适应网站源码爬取过程中,网络爬虫需要识别和解析各种网页布局和样式。

2、响应式布局技术:响应式布局是指根据不同的设备屏幕尺寸和分辨率,自动调整网页布局和样式,在自适应网站源码爬取过程中,需要识别响应式布局的关键技术,如媒体查询(Media Queries)、弹性盒模型(Flexbox)等。

3、CSS选择器:CSS选择器是用于定位网页元素的一种技术,在自适应网站源码爬取过程中,需要利用CSS选择器定位到目标元素,提取出所需信息。

实战应用案例

以下是一个自适应网站源码爬取的实战案例:

1、确定目标网站

图片来源于网络,如有侵权联系删除

确定要爬取的自适应网站,以某电商平台为例,该网站支持多种设备访问,并采用响应式布局。

2、网络爬虫搭建

搭建一个基于Python的爬虫程序,使用BeautifulSoup库解析网页内容,以下是一个简单的爬虫代码示例:

import requests

from bs4 import BeautifulSoup

def get_html(url):

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'

}

response = requests.get(url, headers=headers)

return response.text

def parse_html(html):

soup = BeautifulSoup(html, 'html.parser')

# 使用CSS选择器定位目标元素

elements = soup.select('.target-element')

# 提取所需信息

for element in elements:

print(element.text)

if __name__ == '__main__':

url = 'http://www.example.com'

html = get_html(url)

parse_html(html)3、响应式布局解析

针对响应式布局,可以使用以下方法进行解析:

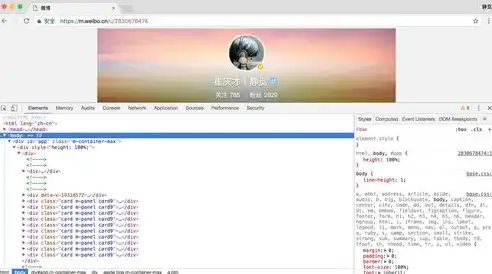

- 查看网站源码,分析响应式布局的关键技术,如媒体查询、弹性盒模型等。

- 使用开发者工具(如Chrome DevTools)模拟不同设备访问网站,观察网页布局变化。

图片来源于网络,如有侵权联系删除

- 编写爬虫代码,根据设备屏幕尺寸和分辨率调整CSS样式,实现响应式布局。

4、爬取结果存储

将爬取到的信息存储到数据库中,方便后续处理和分析。

自适应网站源码爬取是一项具有挑战性的技术,通过对网络爬虫、响应式布局和CSS选择器的掌握,开发者可以轻松实现自适应网站源码的爬取,本文从技术原理和实战应用两个方面对自适应网站源码爬取进行了揭秘,希望对开发者有所帮助。

标签: #自适应网站源码爬取

评论列表