本文目录导读:

随着互联网的快速发展,越来越多的网站和平台出现在我们面前,这些网站为我们提供了丰富的信息和服务,但同时也给我们的数据采集带来了巨大的挑战,如何高效、准确地采集网站PHP源码,成为了许多开发者和数据分析师关注的焦点,本文将深入探讨自动采集网站PHP源码的技巧与挑战,以期为读者提供有益的参考。

自动采集网站PHP源码的原理

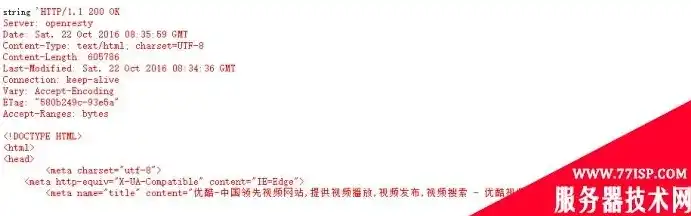

自动采集网站PHP源码,主要是通过分析网站的结构和特点,编写相应的爬虫程序,从目标网站中获取PHP源码,其原理主要包括以下几个步骤:

图片来源于网络,如有侵权联系删除

1、网站分析:需要对目标网站进行详细分析,了解其页面结构、URL规律、数据存储方式等。

2、爬虫编写:根据网站分析结果,编写爬虫程序,实现对目标网站页面的抓取。

3、PHP源码提取:在获取到网页内容后,对网页进行解析,提取其中的PHP源码。

4、数据存储:将提取到的PHP源码进行整理和存储,以便后续分析。

自动采集网站PHP源码的技巧

1、选择合适的爬虫框架:市面上有很多优秀的爬虫框架,如Scrapy、BeautifulSoup等,根据实际需求,选择合适的爬虫框架,可以提高爬虫的效率和稳定性。

图片来源于网络,如有侵权联系删除

2、优化爬虫策略:针对目标网站的特点,制定合理的爬虫策略,如设置合理的爬取频率、避免重复抓取等。

3、处理反爬虫机制:许多网站都设置了反爬虫机制,如IP封禁、验证码等,针对这些机制,可以采取代理IP、更换User-Agent、模拟登录等手段绕过。

4、优化解析算法:在提取PHP源码时,需要对网页进行解析,优化解析算法,可以提高提取效率和准确性。

5、数据清洗和整理:获取到的PHP源码可能存在格式不统一、注释过多等问题,对数据进行清洗和整理,可以提高后续分析的质量。

自动采集网站PHP源码的挑战

1、法律风险:自动采集网站PHP源码可能涉及侵权问题,在实施过程中,需严格遵守相关法律法规,确保不侵犯他人权益。

图片来源于网络,如有侵权联系删除

2、技术难度:自动采集网站PHP源码需要具备一定的编程能力和爬虫经验,对于新手来说,可能会遇到各种技术难题。

3、维护成本:爬虫程序需要定期更新和维护,以适应目标网站的变化,这会增加一定的维护成本。

4、数据质量:采集到的PHP源码可能存在不完整、错误等问题,影响后续分析结果。

自动采集网站PHP源码在数据采集领域具有广泛的应用前景,通过掌握相应的技巧和应对挑战,我们可以高效、准确地获取目标网站的数据,在实施过程中,还需关注法律风险、技术难度和维护成本等问题,只有综合考虑这些因素,才能确保数据采集工作的顺利进行。

标签: #自动采集网站php源码

评论列表