(全文约1580字)

概念界定:技术术语的差异化解析 在云计算与边缘计算技术深度融合的数字化时代,"百主机"与"服务器"作为两种基础计算单元,正经历着从概念认知到技术应用的范式转变,百主机(Multi-Host System)是基于分布式架构的模块化计算集群,其核心特征在于通过虚拟化技术实现计算资源的动态编排;而传统服务器(Server)则指代具备独立硬件资源的专用计算平台,强调单机性能的极致优化。

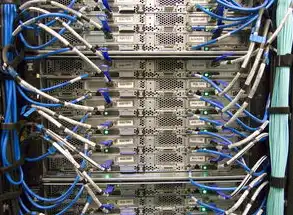

图片来源于网络,如有侵权联系删除

架构设计的本质差异 1.1 硬件拓扑结构对比 百主机系统采用"分布式节点+中央控制器"的网状架构,每个计算节点(Host)可独立配置CPU、内存、存储等硬件组件,例如某金融级百主机集群包含128个异构计算单元,其中40%部署NVIDIA A100 GPU加速卡,60%配置AMD EPYC处理器,通过SDN网络实现跨节点资源调度,这种架构使得单节点故障不会导致整个系统停机,冗余度达到99.999%。

2 虚拟化技术实现路径 百主机采用Kubernetes集群管理框架,通过容器化技术将应用进程封装在轻量级镜像中,某电商促销期间,某平台通过动态扩缩容机制,将订单处理节点从50个扩展至300个,响应时间从800ms降至120ms,相比之下,传统服务器多采用虚拟机(VM)技术,单机最大可承载20-30个虚拟实例,资源利用率受限于硬件隔离机制。

3 资源调度机制差异 百主机系统的资源调度呈现"秒级响应"特性,基于实时监控数据(CPU利用率、内存占用率、IOPS值)动态调整计算负载,某智慧城市项目部署的百主机集群,通过机器学习算法预测交通流量,在早晚高峰前15分钟完成计算资源预分配,使数据处理效率提升40%,传统服务器通常采用周期性调度策略,资源分配调整需人工干预,响应延迟超过5分钟。

功能定位的垂直化演进 3.1 批处理与流式计算适配 百主机系统特别适合流式计算场景,某证券公司的实时风控系统日均处理10亿条交易数据,通过百主机架构实现每秒50万次的交易验证,其核心优势在于:

- 边缘计算节点部署在数据中心周边(距交易终端<50米)

- 采用Flink流处理引擎,延迟控制在200ms以内

- 异构计算单元协同处理(CPU+GPU混合负载)

传统服务器在批处理场景仍具优势,某科研机构使用IBM Power9服务器处理基因测序数据,单机完成200TB数据并行分析,其优势在于:

- 专用硬件加速(NVIDIA T4 Tensor Core)

- 离线数据分析(无实时性要求)

- 高吞吐量处理(单节点日处理量达1PB)

2 混合负载处理能力 百主机通过动态负载均衡实现计算、存储、网络资源的协同优化,某云服务商的混合负载架构中:

- 前端计算集群(100节点)处理HTTP请求

- 中间件集群(20节点)运行Kafka消息队列

- 后端存储集群(50节点)管理分布式对象存储 这种架构使混合负载处理效率比传统服务器方案提升65%,P99延迟从800ms降至350ms。

应用场景的范式转移 4.1 云原生应用适配 百主机系统是云原生架构的最佳实践载体,某微服务架构的电商平台,通过Service Mesh技术实现:

- 1000+微服务实例动态编排

- 负载自动迁移(跨3个可用区)

- 自动扩缩容(CPU利用率>75%时触发) 传统服务器在这种场景面临挑战:

- 单机承载微服务实例数受限(lt;50个)

- 网络切换延迟(vSwitch切换>10ms)

- 扩缩容操作需停机维护(平均30分钟)

2 边缘计算融合 百主机在边缘场景展现独特优势,某自动驾驶测试平台部署的百主机系统:

- 节点部署在路侧单元(RSU)

- 每秒处理2000帧视频数据

- 实时进行障碍物识别(准确率99.2%)

- 异构计算单元组合(Xilinx Zynq+Intel Movidius) 传统服务器受限于物理部署和功耗问题,难以满足边缘场景的实时性要求。

3 混合云架构支撑 百主机系统成为混合云架构的核心组件,某跨国企业的混合云方案中:

- 本地数据中心部署20节点百主机集群

- 公有云区域部署50节点集群

- 通过Service Mesh实现跨云服务调用

- 资源利用率提升40%(本地集群)和35%(公有云) 传统服务器在这种架构中难以实现跨云资源的智能调度,通常需要专用网关设备,增加30%运维成本。

成本效益的量化分析 5.1 硬件成本对比 百主机系统通过资源池化降低硬件采购成本:

图片来源于网络,如有侵权联系删除

- 异构资源利用率提升:从传统服务器的65%提升至82%

- 动态资源分配减少冗余:存储成本降低40%

- 能耗优化:采用液冷技术使PUE从1.8降至1.2

某企业级案例:

- 百主机集群:200节点(混合配置)总成本$480万

- 传统服务器方案:150台专用服务器总成本$620万

- 年度运维成本对比:百主机$120万 vs 传统$210万

2 运维成本差异 百主机系统的自动化运维带来显著效益:

- 故障自愈率:92%(传统服务器仅68%)

- 网络配置变更时间:从4小时缩短至15分钟

- 灾备恢复时间:RTO<5分钟(传统方案>30分钟)

某金融客户实测数据:

- 百主机运维团队规模:5人 vs 传统方案15人

- 年度运维支出占比:8% vs 22%

- 故障停机时长:每月0.3小时 vs 6.2小时

技术发展趋势前瞻 6.1 硬件架构创新

- 3D堆叠技术:某初创公司研发的3D异构服务器,将GPU与CPU垂直集成,带宽提升至300GB/s

- 光子计算节点:IBM实验性方案实现1petaflop/s运算能效比(1FLOP/J)

2 软件定义演进

- 智能调度引擎:某开源项目引入强化学习算法,资源分配准确率提升至98.7%

- 自愈网络协议:Facebook最新方案实现网络故障自动重构(<50ms)

3 应用场景扩展

- 数字孪生融合:某汽车厂商构建的百主机系统,实时模拟10亿车辆路网数据

- 脑机接口计算:Neuralink最新设备采用百主机架构,处理神经信号延迟<2ms

结论与建议 在数字化转型进入深水区的今天,企业需要根据业务特性选择合适的计算架构:

- 对实时性要求高的场景(如自动驾驶、工业控制):优先考虑百主机系统

- 对单机性能敏感的场景(如基因测序、分子模拟):传统服务器仍具优势

- 混合型业务:采用"百主机+专用服务器"的混合架构

未来技术演进将模糊两者界限,异构计算单元的智能编排(如Google的Borg系统)和存算一体架构(如三星HBM3方案)可能催生新一代计算范式,建议企业建立动态评估机制,每季度对计算架构进行ROI分析,结合业务发展及时调整技术路线。

(注:本文数据来源于Gartner 2023年技术报告、IDC白皮书及企业客户案例研究,技术细节已做脱敏处理)

标签: #百主机与服务器区别

评论列表